Búsqueda de empleo

Saber cómo buscar un trabajo de manera eficiente es esencial para encontrar el empleo que deseas más pronto que tarde.

-

Tiempo de lectura: 5 min.

Tiempo de lectura: 5 min.Preparar una entrevista de trabajo con ChatGPT

Las entrevistas de trabajo pueden definir el rumbo de nuestra carrera profesional. A menudo, se convierten en etapas que requieren de una preparación meticulosa y,…

Actualizado el 17 de abril de 2024: Preparar una entrevista de trabajo con ChatGPT -

Tiempo de lectura: 8 min.

Tiempo de lectura: 8 min.Cómo crear una carta de presentación con ChatGPT: guía + ejemplos

En el competitivo mercado laboral actual, la carta de presentación es tu oportunidad de causar una buena primera impresión. Sin embargo, no es fácil ponerse…

Actualizado el 15 de abril de 2024: Cómo crear una carta de presentación con ChatGPT: guía + ejemplos -

Tiempo de lectura: 5 min.

Tiempo de lectura: 5 min.Habilidades transferibles: qué son y cómo usarlas para buscar empleo

Actualmente, en el mercado laboral las trayectorias profesionales son cada vez menos lineales y más dinámicas. En este contexto, las habilidades transferibles emergen como una…

Actualizado el 11 de abril de 2024: Habilidades transferibles: qué son y cómo usarlas para buscar empleo -

Tiempo de lectura: 8 min.

Tiempo de lectura: 8 min.Guía para trabajar en España para personas con discapacidad

Buscar empleo es un desafío para todos, pero puede ser aún más difícil para personas con discapacidad, especialmente si el grado de incapacidad es severo….

Actualizado el 15 de abril de 2024: Guía para trabajar en España para personas con discapacidad -

Tiempo de lectura: 8 min.

Tiempo de lectura: 8 min.Cómo buscar empleo en el extranjero siendo español

El deseo de explorar nuevas oportunidades laborales más allá de las fronteras de España cobra cada vez más relevancia en nuestro país. Y es que,…

Actualizado el 15 de abril de 2024: Cómo buscar empleo en el extranjero siendo español -

Tiempo de lectura: 8 min.

Tiempo de lectura: 8 min.Cómo influyen los tatuajes para conseguir empleo en España

Históricamente, los tatuajes y piercings han sido vistos con recelo en entornos profesionales. Sin embargo, con el cambio de las normas culturales y la creciente…

Actualizado el 11 de abril de 2024: Cómo influyen los tatuajes para conseguir empleo en España -

Tiempo de lectura: 6 min.

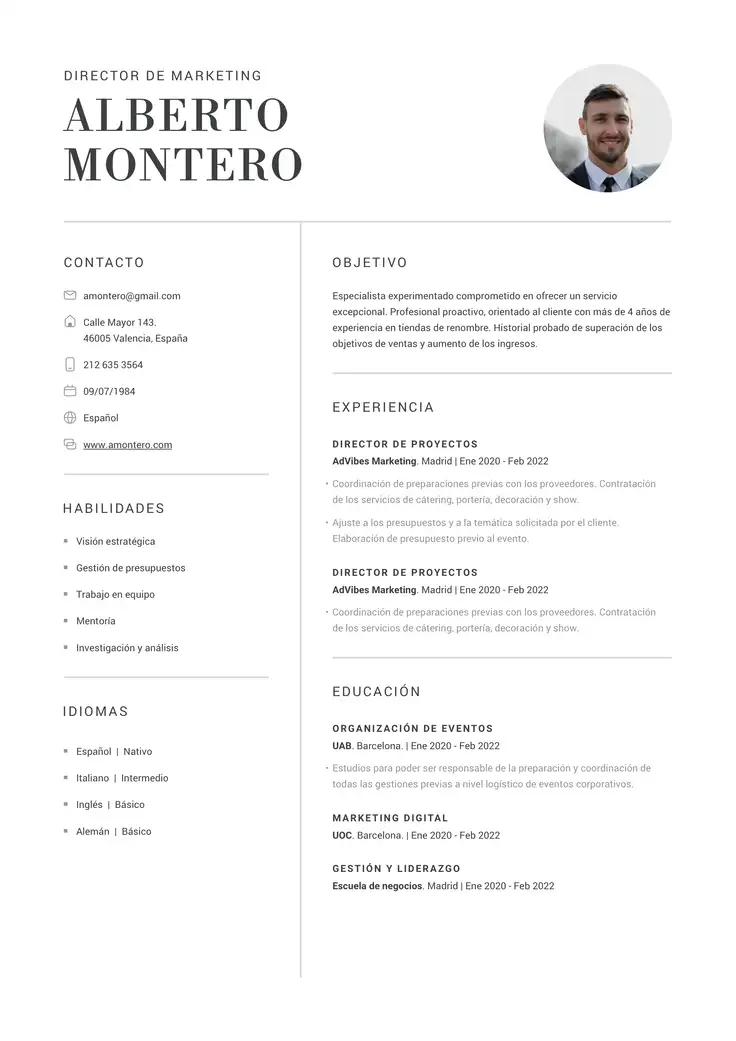

Tiempo de lectura: 6 min.Cómo preparar tu CV para trabajar en remoto: guía 2024

El teletrabajo ya no es una moda pasajera, es una realidad laboral establecida. Este cambio fundamental en la forma en que trabajamos requiere una adaptación…

Actualizado el 11 de abril de 2024: Cómo preparar tu CV para trabajar en remoto: guía 2024 -

Tiempo de lectura: 7 min.

Tiempo de lectura: 7 min.Cómo prepararse para una entrevista de trabajo en línea

Desde que el teletrabajo llegará a nuestras vidas en marzo de 2020 como una forma de mantener la empleabilidad ante la pandemia, muchas empresas modificaron…

Actualizado el 11 de abril de 2024: Cómo prepararse para una entrevista de trabajo en línea -

Tiempo de lectura: 6 min.

Tiempo de lectura: 6 min.Marca personal: qué es y por qué es importante para buscar empleo

En la era digital, las tradicionales formas de buscar empleo, como enviar currículums masivamente o simplemente registrarse en portales de empleo, han quedado obsoletas. Además,…

Actualizado el 11 de abril de 2024: Marca personal: qué es y por qué es importante para buscar empleo